"אפשר לאמן בינה מלאכותית להרוג בני אדם"

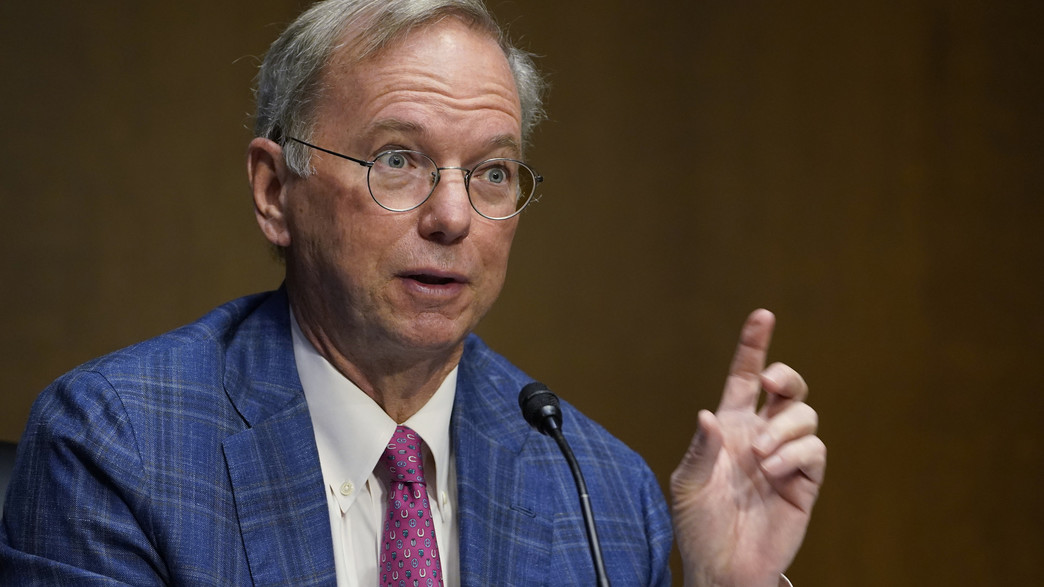

מנכ"ל גוגל לשעבר, אריק שמידט, השמיע בכנס בלונדון הערכה פסימית לגבי השימוש האנושי בבינה מלאכותית: "ניתן לפרוץ את המודלים כדי להסיר את תקנות הבטיחות שלהן".

מנכ"ל גוגל לשעבר, אריק שמידט, הזהיר כי מודלים של בינה מלאכותית עלולים להיות מאומנים במטרה לחסל בני אדם אם הם נופלים לידיים הלא נכונות. בכנס בלונדון בשבוע שעבר נשאל שמידט האם בינה מלאכותית עלולה להפוך למסוכנת יותר מנשק גרעיני, והשיב: "ישנן ראיות לכך שאפשר לקחת מודלים, סגורים או פתוחים, וניתן לפרוץ אותם כדי להסיר את הגדרות הבטיחות שלהם. אז, במהלך האימונים שלהם, הם לומדים הרבה דברים. דוגמה גרועה לכך תהיה שהם לומדים איך להרוג מישהו".

"כל החברות הגדולות גורמות למודלים האלה לא להיות מסוגלים לענות על השאלה הזו. החלטה טובה. כולם עושים את זה. הם עושים את זה טוב, והם עושים את זה מהסיבות הנכונות", הוסיף שמידט. "ישנן ראיות לכך שניתן לבצע הנדסה הפוכה של שיטות אלו".

דבריו של שמידט אינם מופרכים: לפני כשנתיים צצה ברשת גרסה פרוצה של צ'אט GPT שנקרא DAN (Do Anything Now), שהצליחה לעקוף את הגדרות הבטיחות של הצ'אט ואיימה על המשתמשים. באופן ביזארי, ניתן היה להשיב את הצ'אט למוטב אם המשתמש היה בעצמו מאיים עליו במוות.

רק לפני כחודשיים הזהיר בכיר אחר לשעבר בגוגל, מו גאוודט, שכיהן כראש תחום העסקים של Google X, כי הבינה המלאכותית תוביל את החברה האנושית ל-15 שנים של שיבושים קשים וסבל, כאשר היא תביא לחיסול של עבודות רבות במגזר הצווארון הלבן. "הגיהנום" הזה, לדבריו, עשוי להתחיל כבר ב-2027.